大模型基准测试体系研究报告(2024年)

大模型基准测试:驱动AI技术进步的基石与未来展望

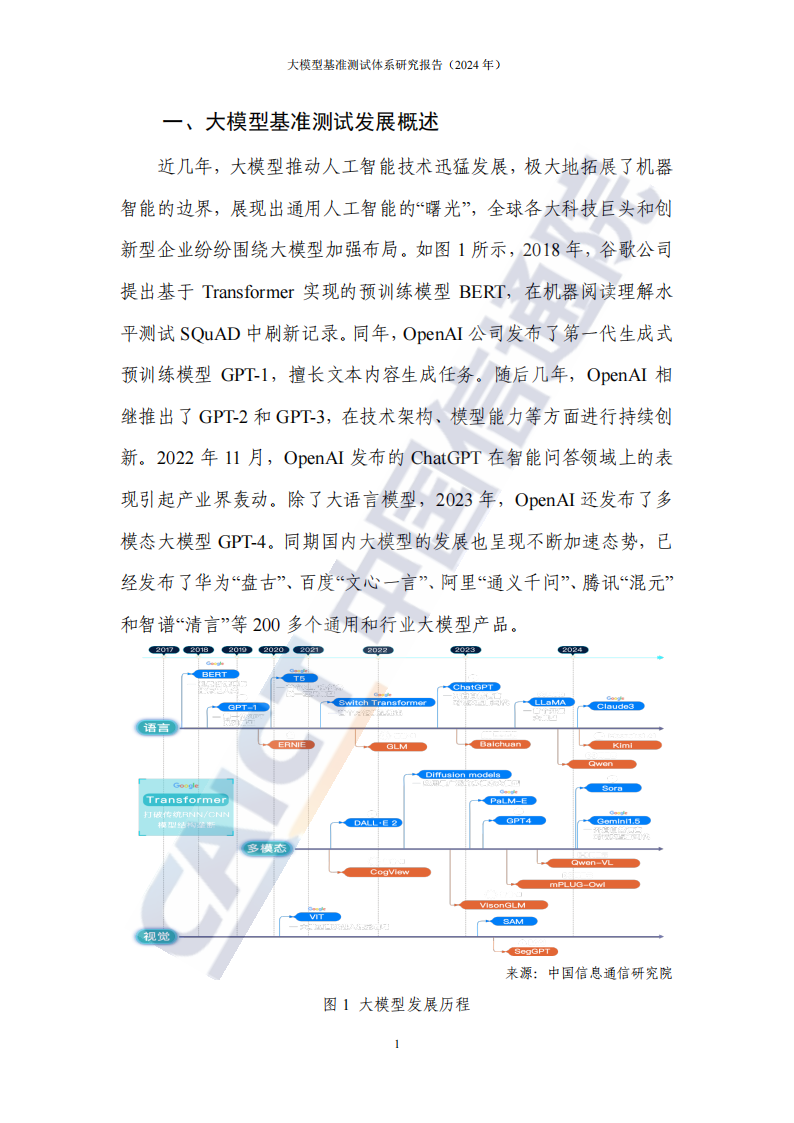

近年来,大模型作为人工智能领域的璀璨明星,以其强大的计算能力和广泛的学习范围,极大地推动了人工智能技术的飞跃,预示着通用人工智能时代的曙光初现。在此背景下,如何科学、精准地评估大模型的能力,成为学术界、产业界、研究机构及用户群体共同关注的焦点。构建一套全面、客观、可量化的基准测试体系,不仅是对当前技术成就的检验,更是对未来研究方向的指引,对产品研发的驱动,对行业应用的支撑,以及对监管治理的辅助,同时也是增进公众对AI技术理解的重要途径。

一、现状回顾与问题剖析

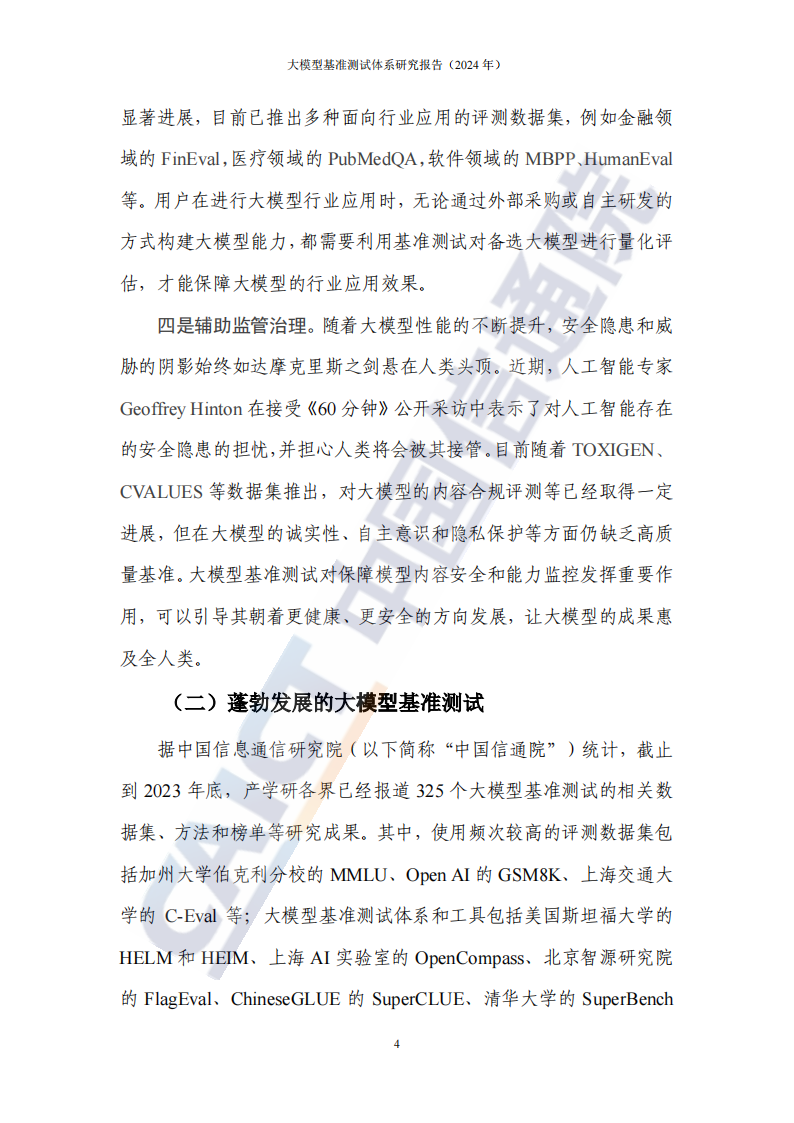

当前,全球范围内的顶尖学术机构和领军企业纷纷投身于大模型基准测试的探索与实践,通过发布多样化的评测数据集、框架及结果榜单,有效促进了大模型技术的持续进步。然而,随着大模型能力的日益增强及其在各行业的广泛应用,现有基准测试体系面临着诸多挑战与不足,如测试场景的局限性、评估指标的单一性、跨平台兼容性问题等,均制约了测试的全面性和有效性。

二、“方升”大模型基准测试体系的提出

针对上述问题,本研究报告创新性地提出了“方升”大模型基准测试体系,旨在通过系统化、标准化的方法,构建一套全面覆盖大模型能力维度的测试框架。该体系不仅涵盖了多样化的测试任务与数据集,还引入了多维度、精细化的评估指标,以实现对大模型性能、鲁棒性、可解释性等多方面的综合评价。同时,“方升”体系还注重跨平台、跨技术的兼容性,确保测试结果的广泛认可与可比性。

三、初步实践与未来展望

基于“方升”体系,我们已经初步开展了一系列大模型评测工作,取得了阶段性成果。这些评测不仅验证了“方升”体系的可行性与有效性,也为后续的优化与完善提供了宝贵的数据支持与经验积累。展望未来,大模型基准测试仍面临着诸多开放性问题与挑战,如如何更好地模拟真实世界场景、如何设计更加精细化的评估指标、如何促进跨领域基准测试标准的统一等。

四、结语

大模型基准测试是推动人工智能技术持续进步的关键环节。面对未来,我们呼吁产学研各界加强合作,共同建设完善的大模型基准测试标准体系,为大模型行业的健康有序发展提供坚实支撑。通过不懈努力,我们有理由相信,大模型技术将在更加科学、规范的基准测试体系下,迎来更加辉煌的明天,为人类社会带来前所未有的变革与福祉。