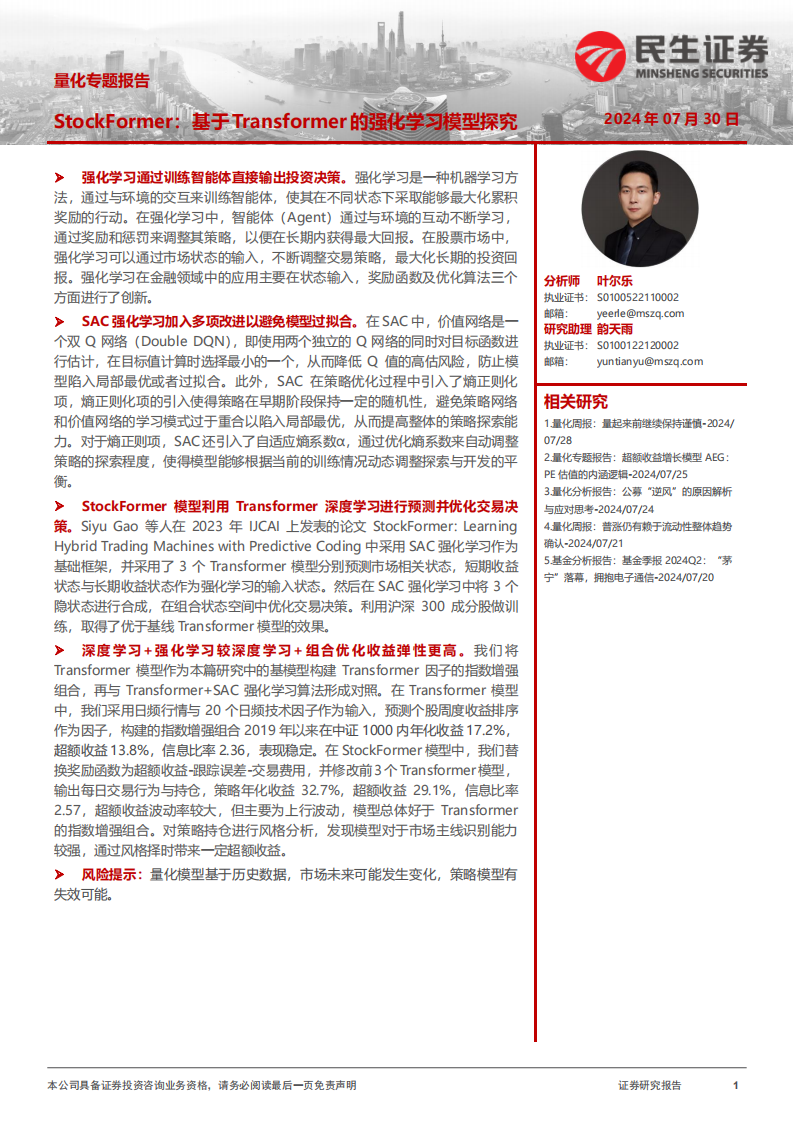

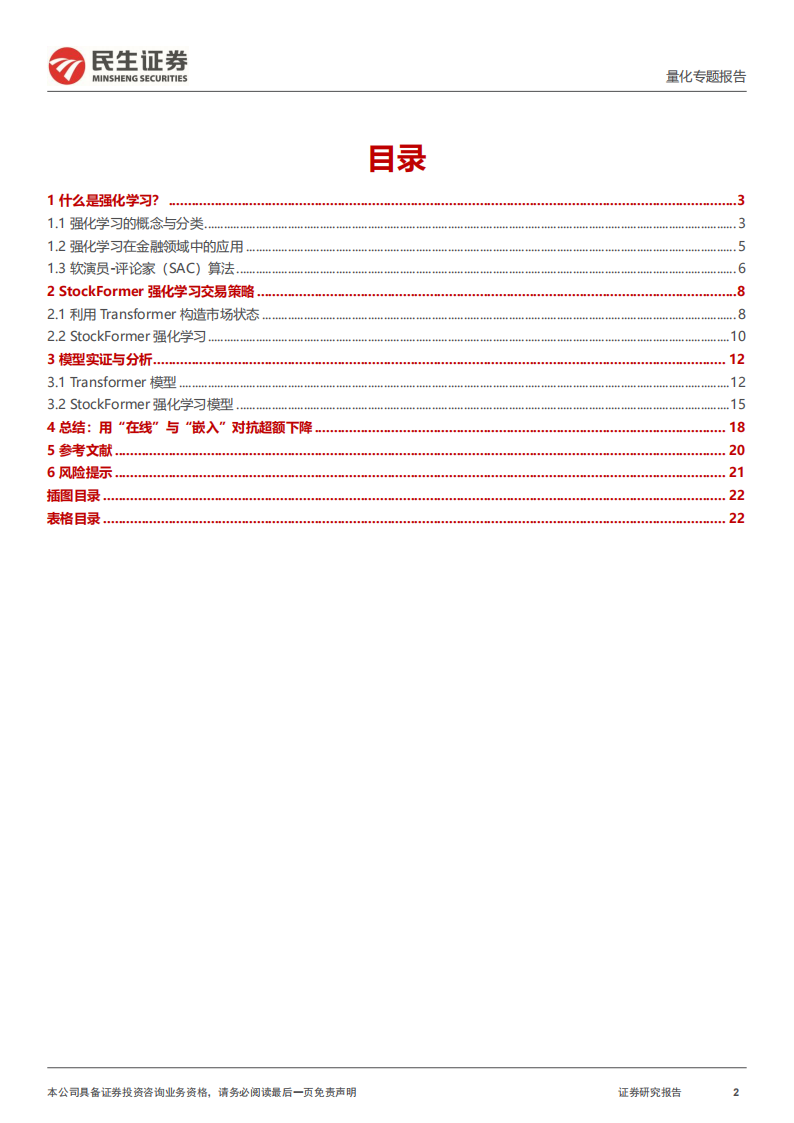

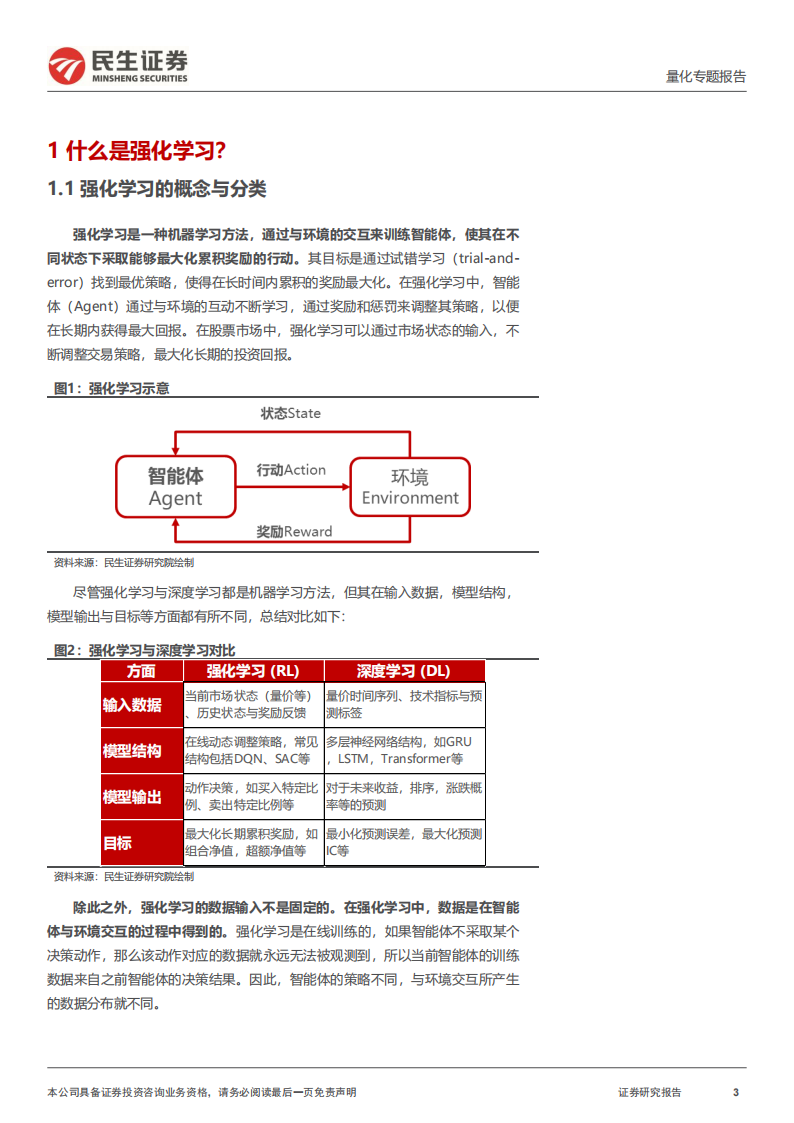

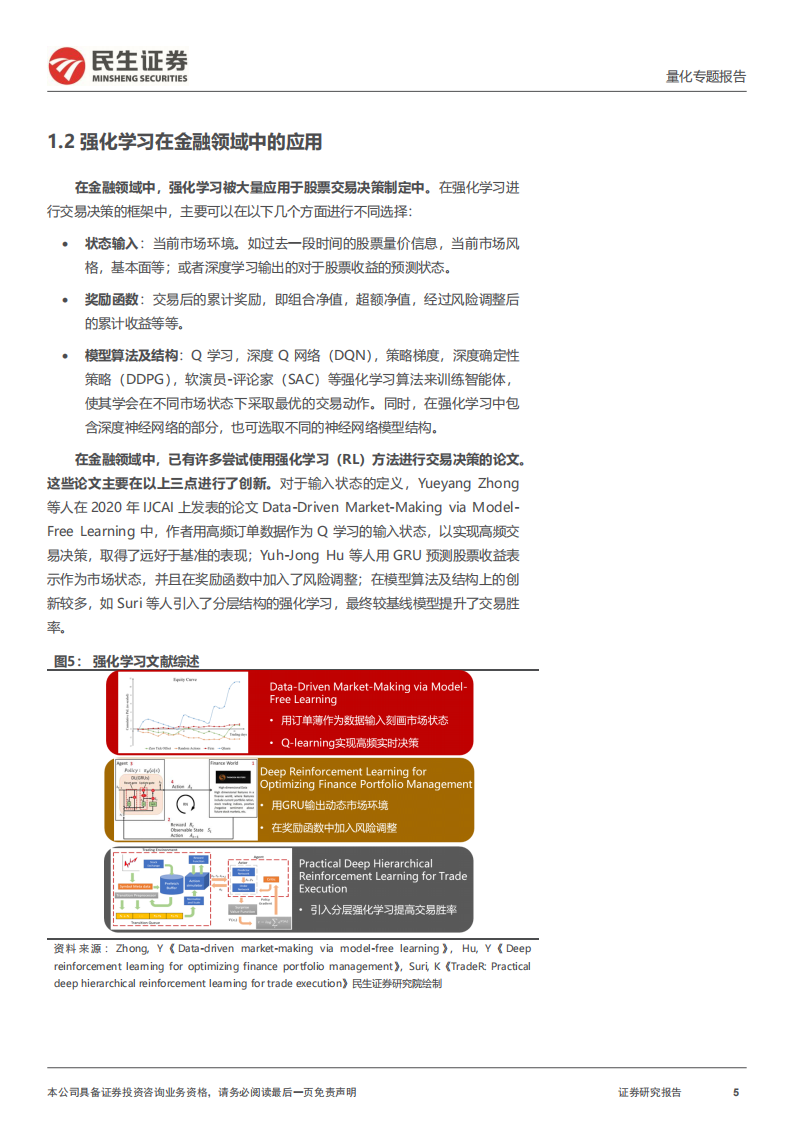

强化学习通过训练智能体直接输出投资决策。强化学习是一种机器学习方法,通过与环境的交互来训练智能体,使其在不同状态下采取能够最大化累积奖励的行动。在强化学习中,智能体(Agent)通过与环境的互动不断学习,通过奖励和惩罚来调整其策略,以便在长期内获得最大回报。在股票市场中,强化学习可以通过市场状态的输入,不断调整交易策略,最大化长期的投资回报。强化学习在金融领域中的应用主要在状态输入,奖励函数及优化算法三个方面进行了创新。

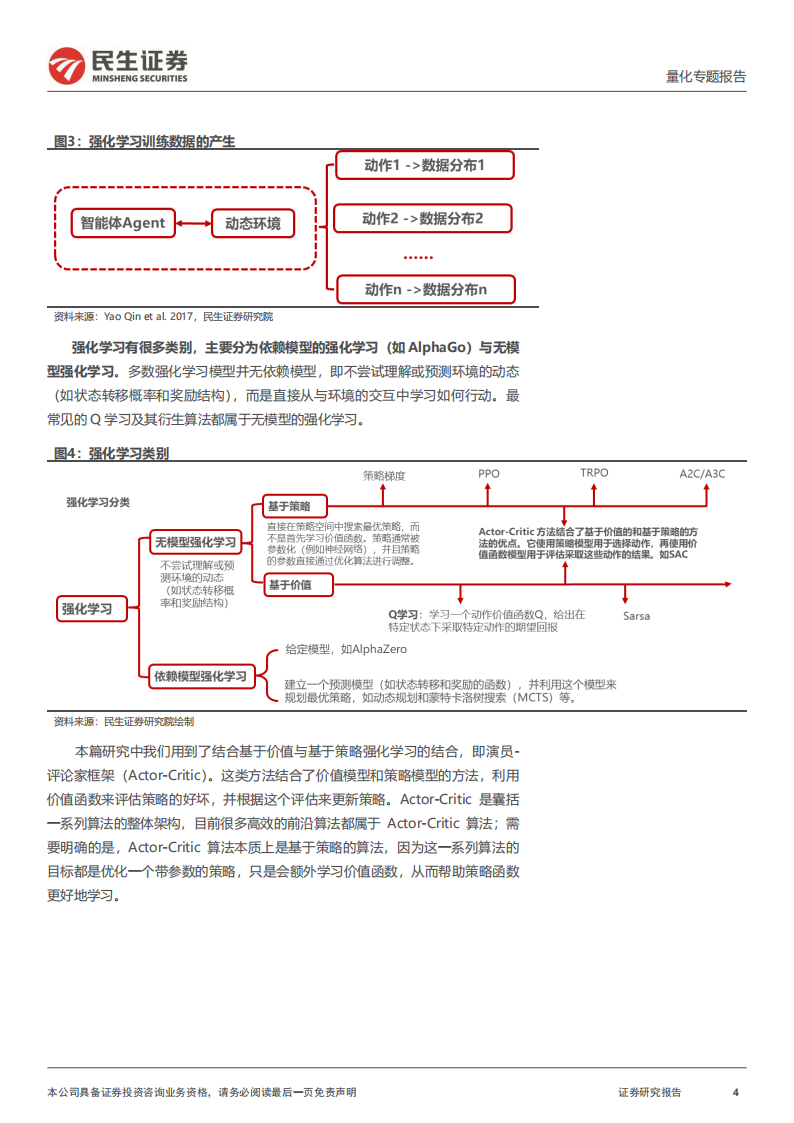

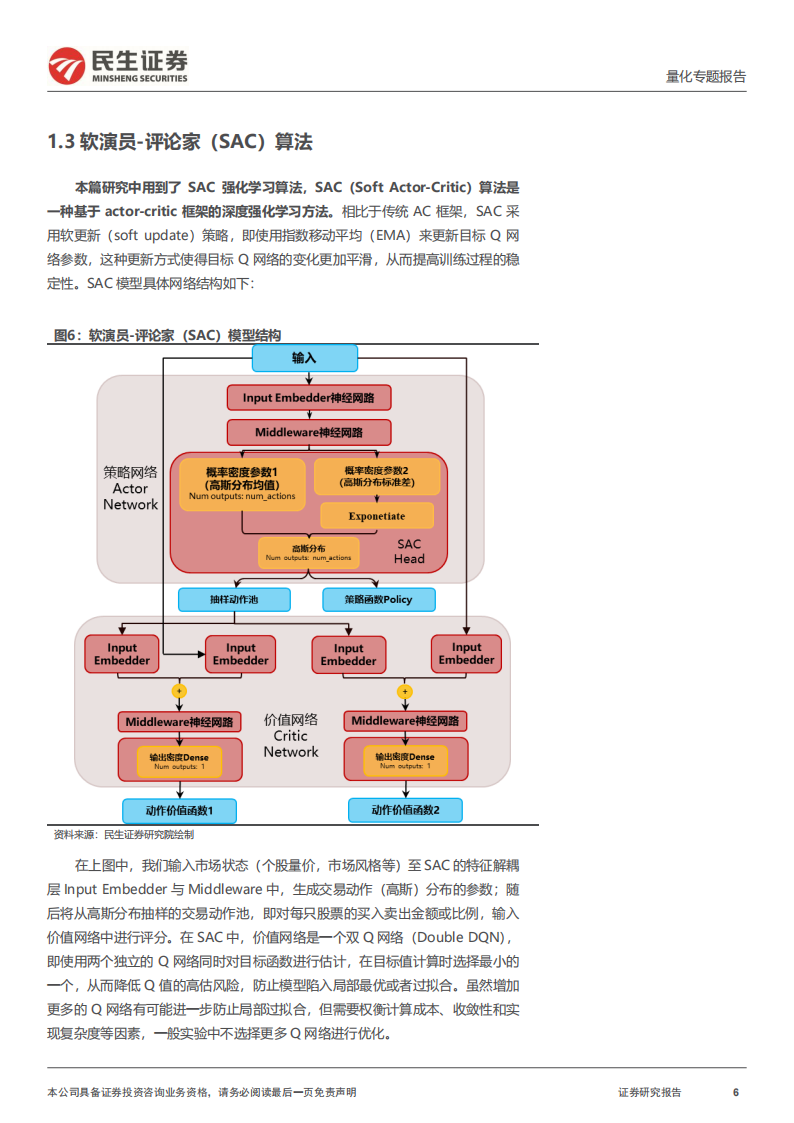

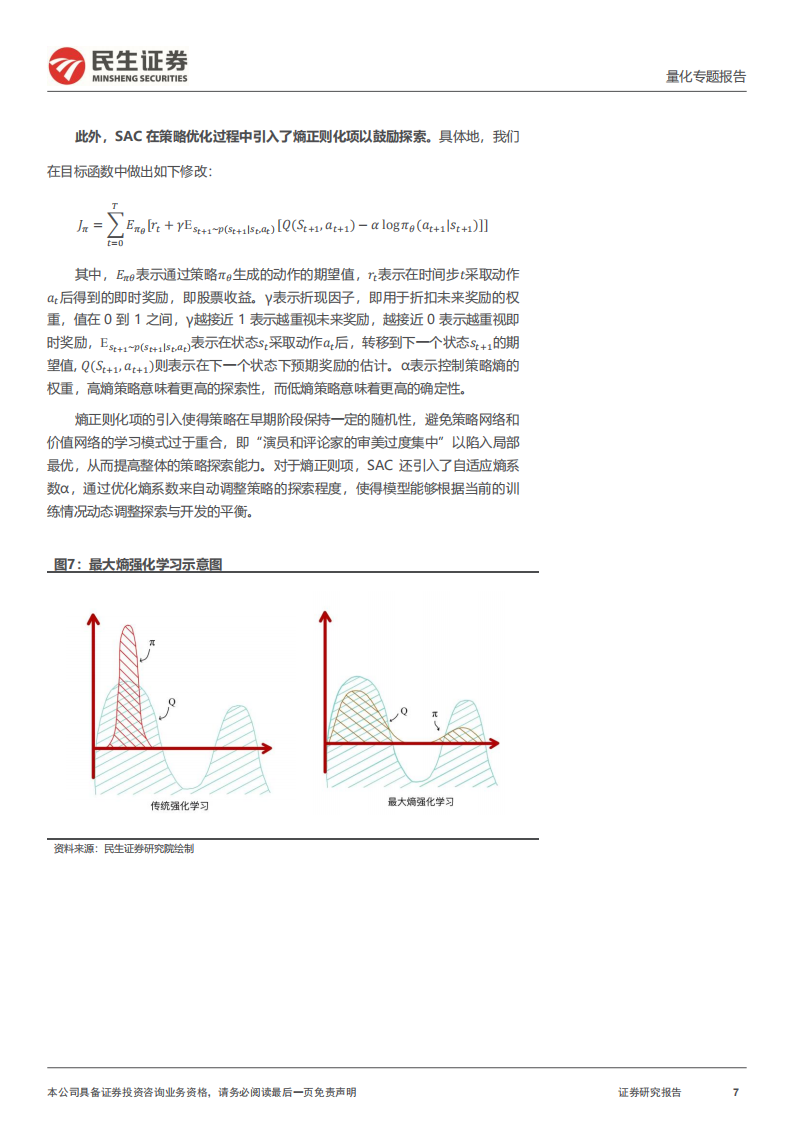

SAC 强化学习加入多项改进以避免模型过拟合。在 SAC 中,价值网络是一个双 Q 网络(Double DQN),即使用两个独立的 Q 网络的同时对目标函数进行估计,在目标值计算时选择最小的一个,从而降低 Q 值的高估风险,防止模型陷入局部最优或者过拟合。此外,SAC 在策略优化过程中引入了熵正则化项,熵正则化项的引入使得策略在早期阶段保持一定的随机性,避免策略网络和价值网络的学习模式过于重合以陷入局部最优,从而提高整体的策略探索能力。对于熵正则项,SAC 还引入了自适应熵系数α,通过优化熵系数来自动调整策略的探索程度,使得模型能够根据当前的训练情况动态调整探索与开发的平衡。

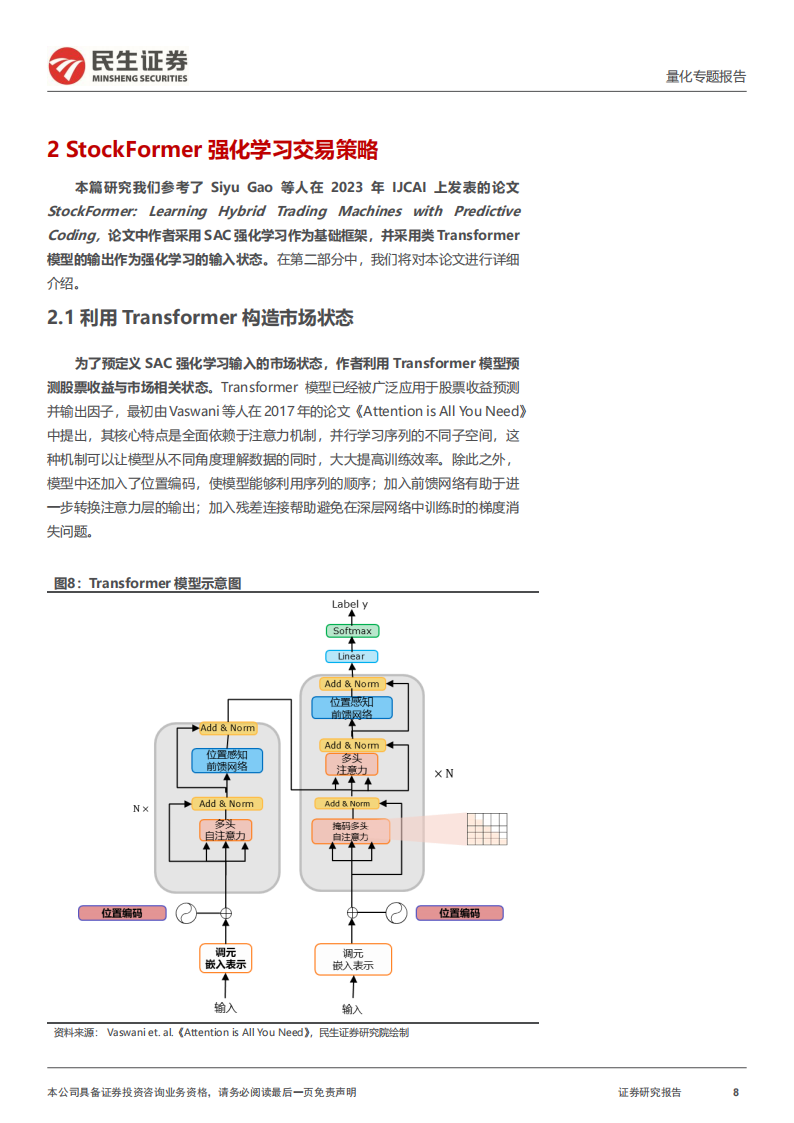

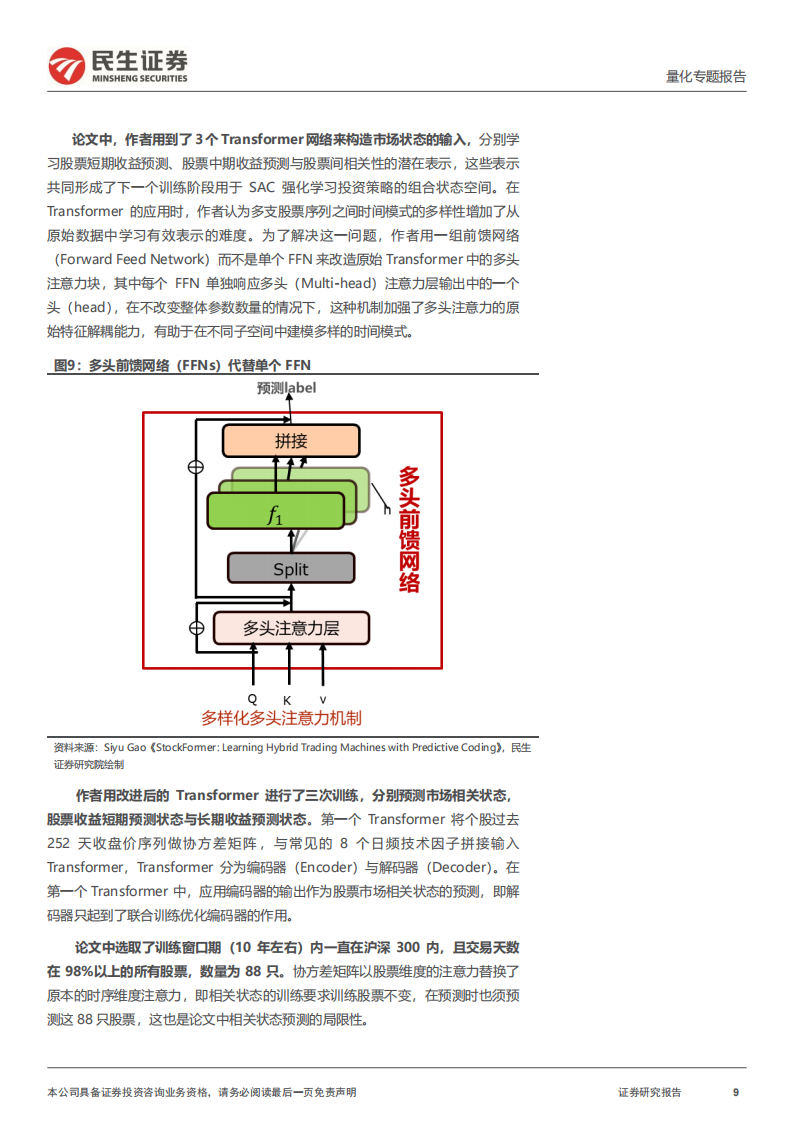

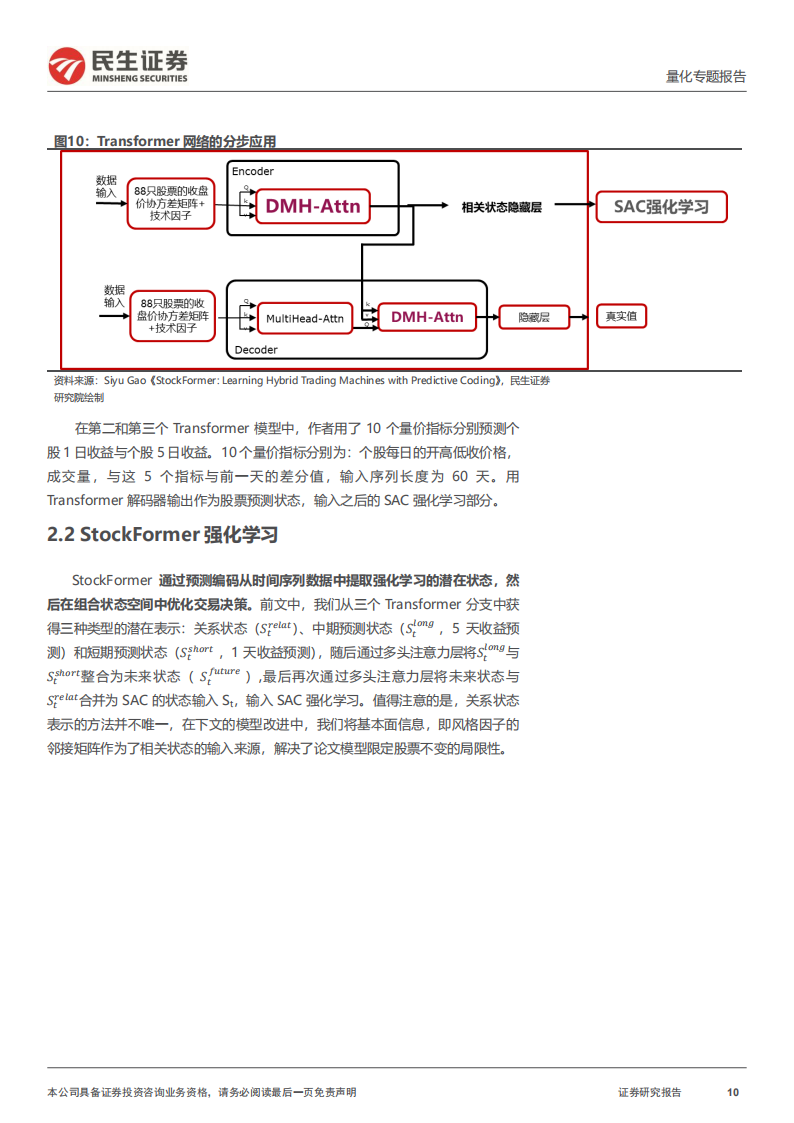

StockFormer 模型利用 Transformer 深度学习进行预测并优化交易决策。Siyu Gao 等人在 2023 年 IJCAI 上发表的论文 StockFormer: Learning Hybrid Trading Machines with Predictive Coding 中采用 SAC 强化学习作为基础框架,并采用了 3 个 Transformer 模型分别预测市场相关状态,短期收益状态与长期收益状态作为强化学习的输入状态。然后在 SAC 强化学习中将 3 个隐状态进行合成,在组合状态空间中优化交易决策。利用沪深 300 成分股做训练,取得了优于基线 Transformer 模型的效果。

深 度学 习+强 化学 习较深 度学 习+组 合优 化收益 弹性 更高。我们 将Transformer 模型作为本篇研究中的基模型构建 Transformer 因子的指数增强组合,再与 Transformer+SAC 强化学习算法形成对照。在 Transformer 模型中,我们采用日频行情与 20 个日频技术因子作为输入,预测个股周度收益排序作为因子,构建的指数增强组合 2019 年以来在中证 1000 内年化收益 17.2%,超额收益 13.8%,信息比率 2.36,表现稳定。在 StockFormer 模型中,我们替换奖励函数为超额收益-跟踪误差-交易费用,并修改前3个Transformer模型,输出每日交易行为与持仓,策略年化收益 32.7%,超额收益 29.1%,信息比率2.57,超额收益波动率较大,但主要为上行波动,模型总体好于 Transformer的指数增强组合。对策略持仓进行风格分析,发现模型对于市场主线识别能力较强,通过风格择时带来一定超额收益。