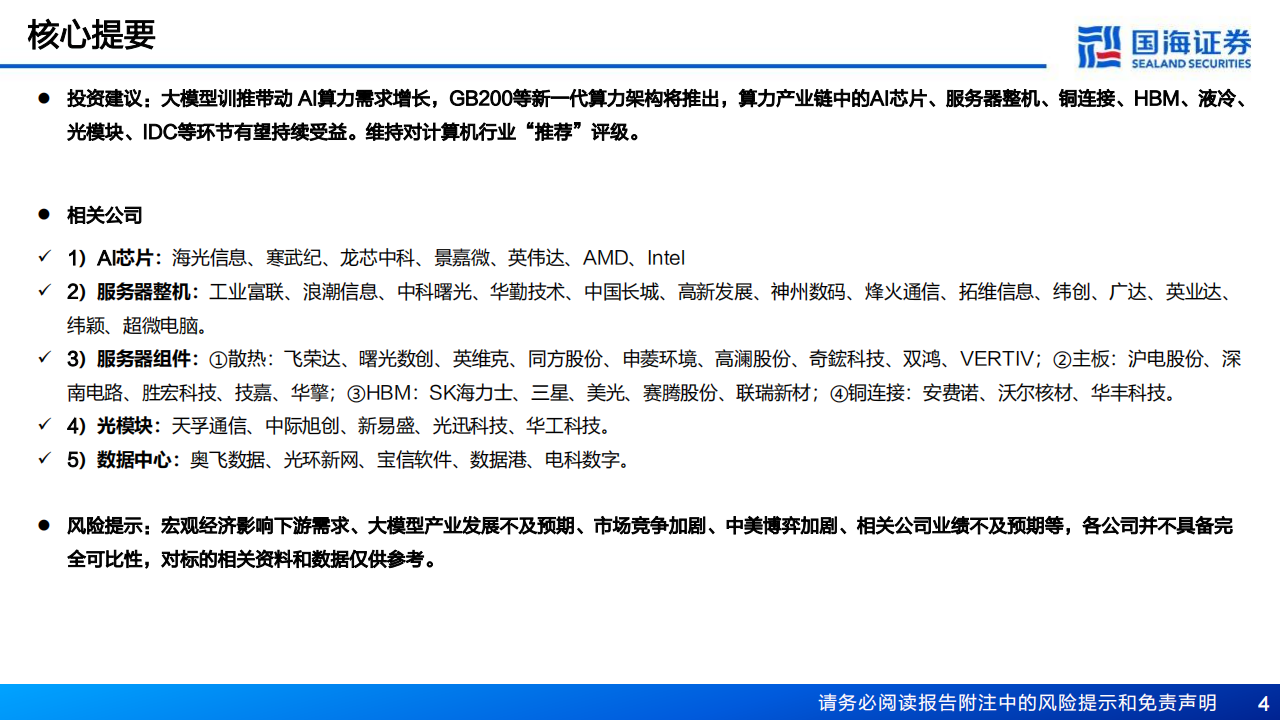

NV Blackwell 系列或于 2024Q4 推出,有望提升机柜、铜缆、液冷、HBM 四个市场的价值量。具体内容如下:

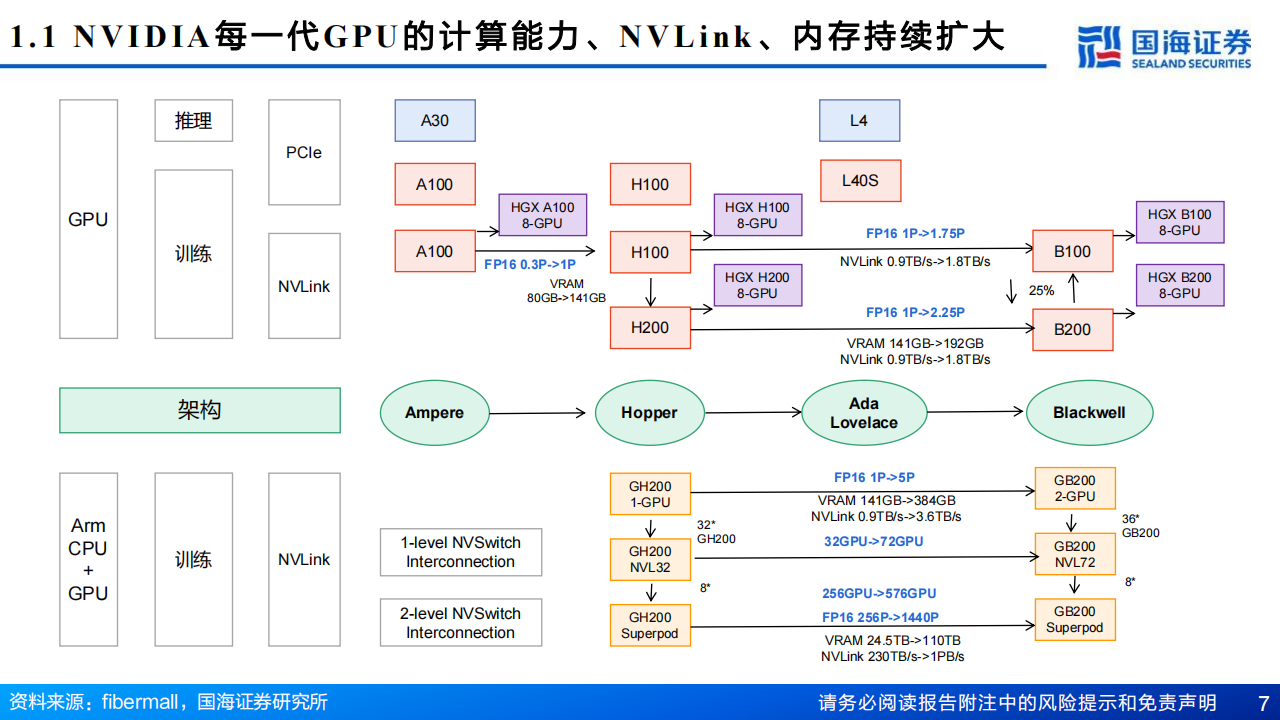

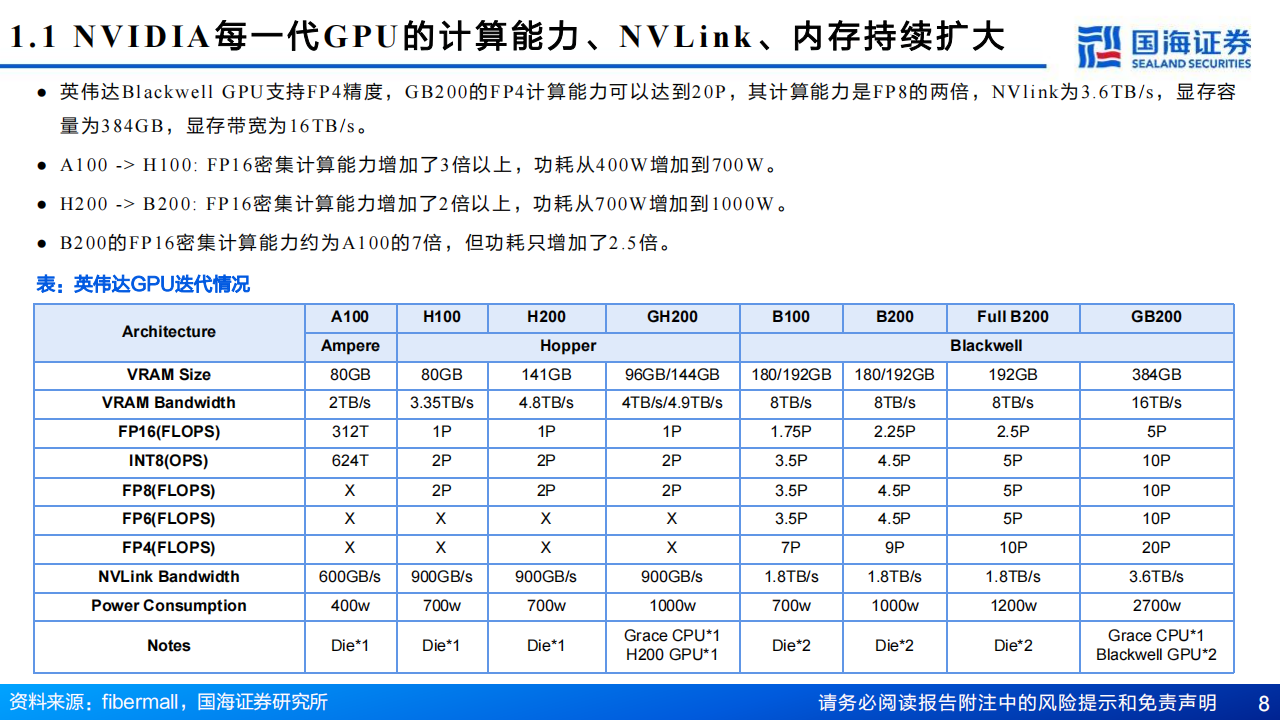

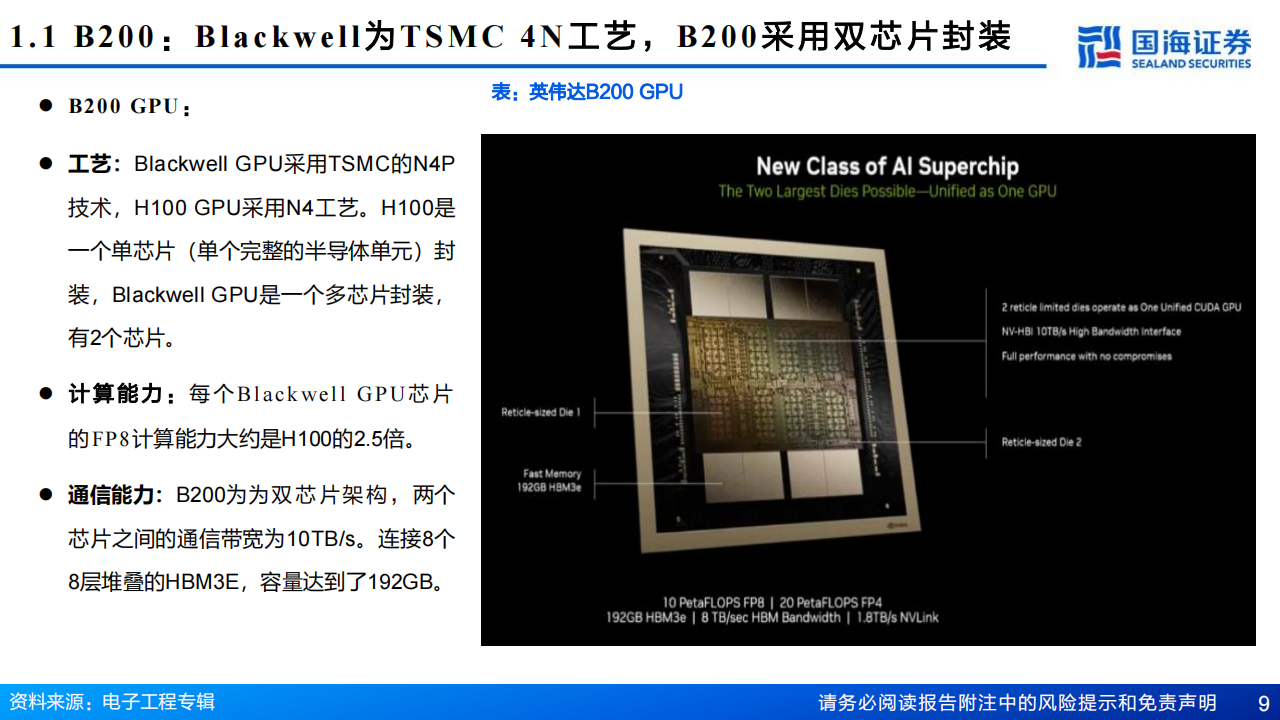

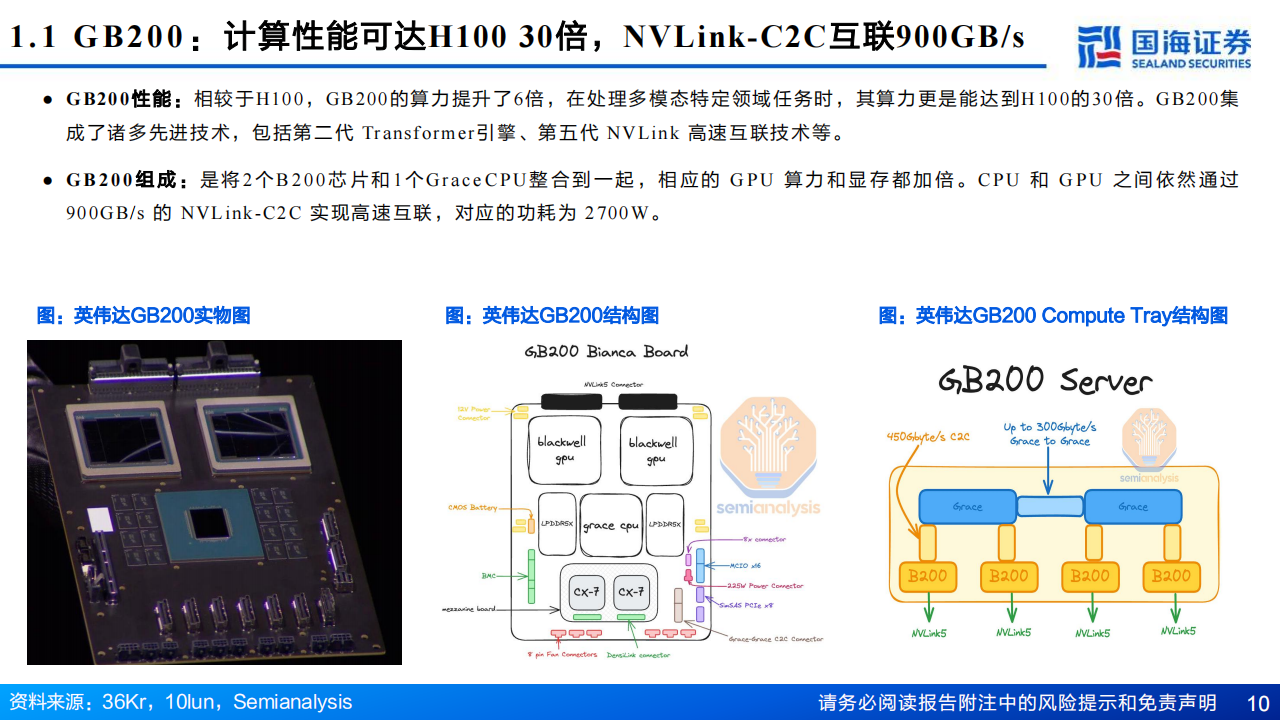

Blackwell 系列:GB200 计算能力远超 H100,采用台积电 N4P 制程,双芯片架构,192GB HBM3E,AI算力达 20petaFLOPS(FP4)。GB200 机架有 4 种不同外形尺寸可定制,其 NVL72 与 H100 相比,将训练速度提高 30 倍。Meta、Alphabet(谷歌)、微软、亚马逊等互联网厂商均增加 2024 年资本开支指引。

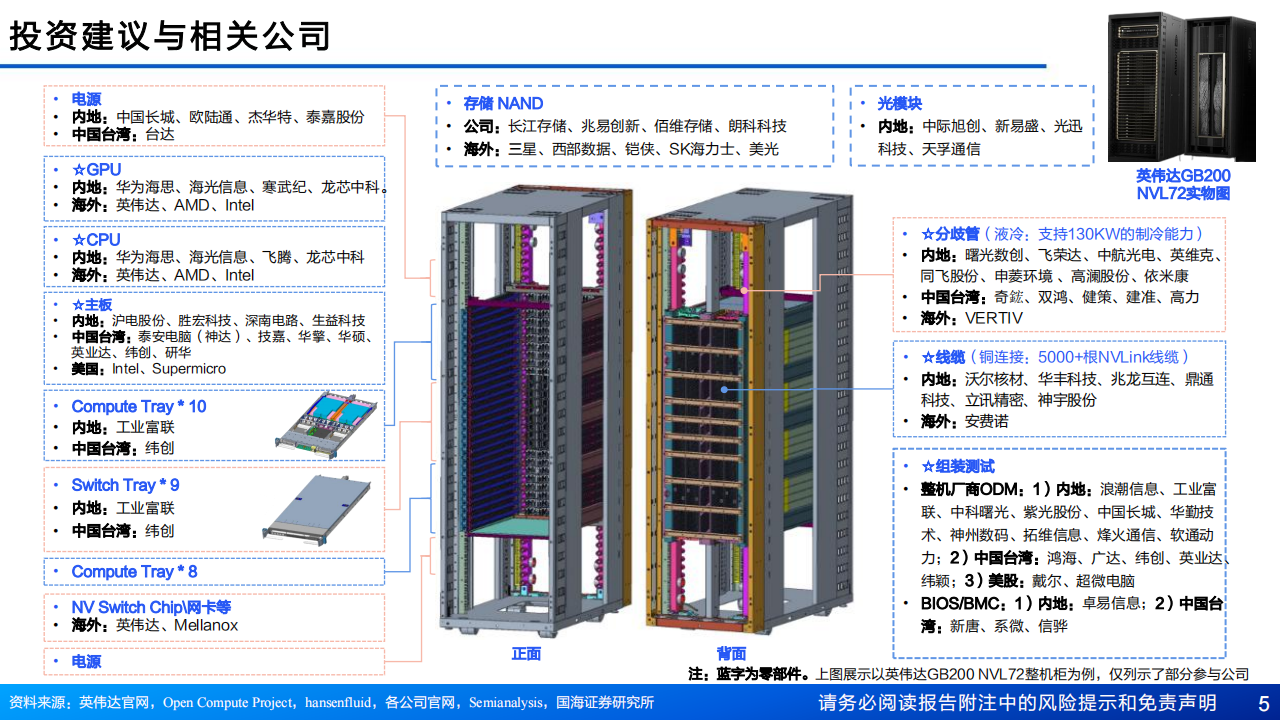

服务器细节拆分:GB200 主板从 HGX 模式变为 MGX,MGX 是开放模块化服务器设计规范和加速计算设计,在 Blackwell 系列大范围使用。MGX 模式下,GB200 Switch tray 主要由工业富联生产,Compute Tray 由纬创与工业富联共同生产后交付给英伟达。有望带来四个市场价值量 2 - 10 倍提升。

铜连接:高速线缆中,有源光缆适合远距离传输,直连电缆高速低功耗。据 LightCounting,高速线缆规模预期 28 年达 28 亿美元,DACs 保持较快增长,Nvidia 尽可能多地部署 DACs。2022 年全球前十强厂商占据约 69.0% 市场份额,安费诺居首,国内厂商包括立讯精密、兆龙互联、金信诺、电联技术等,但全球市占率较低。

HBM:HBM 有五个子代标准,HBM3E 下半年出货,HBM4 或于 2026 年上市。2024 年底 HBM TSV 产能约 250K/m,三星与海力士扩产积极,英伟达是 HBM 最大买家,海力士与三星完成 HBM3E 验证。

冷板式液冷:AI 大模型训推提升单芯片功耗,英伟达 B200 功耗超 1000W,接近风冷散热上限。液冷技术包括冷板式与浸没式,冷板式为间接冷却,初始投资中等,运维成本较低,相对成熟,GB200 NVL72 采用冷板式液冷解决方案。