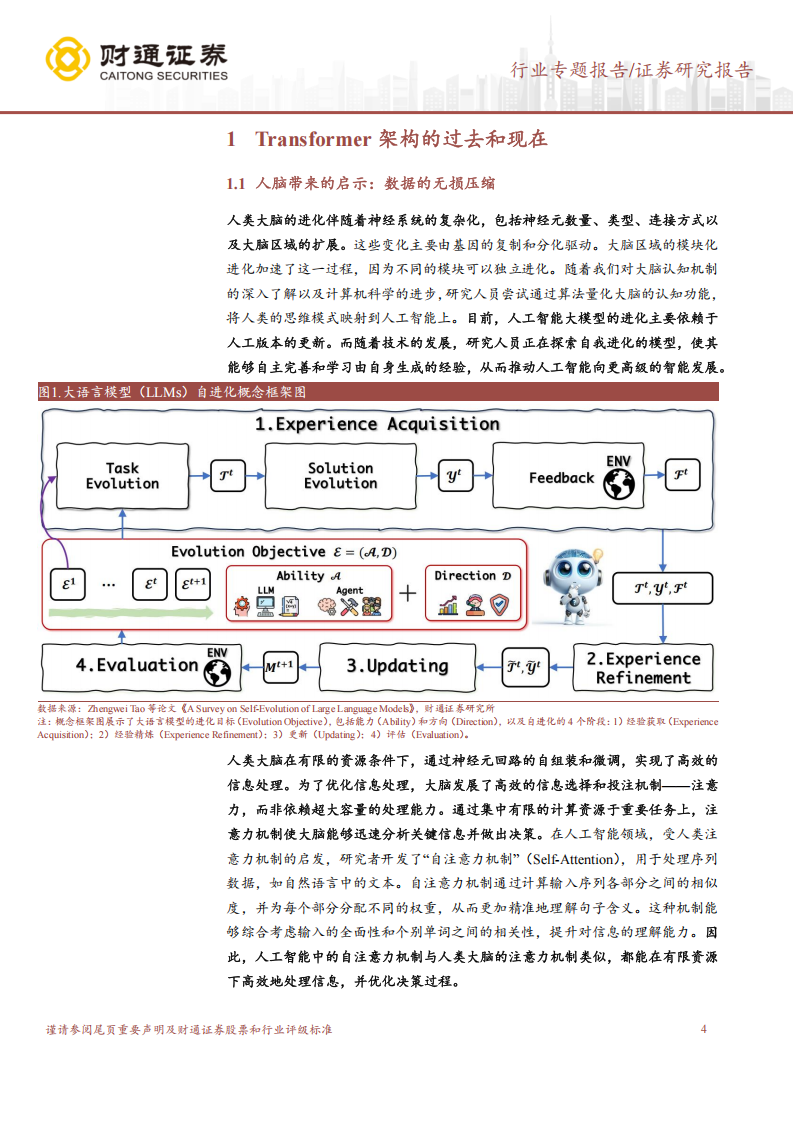

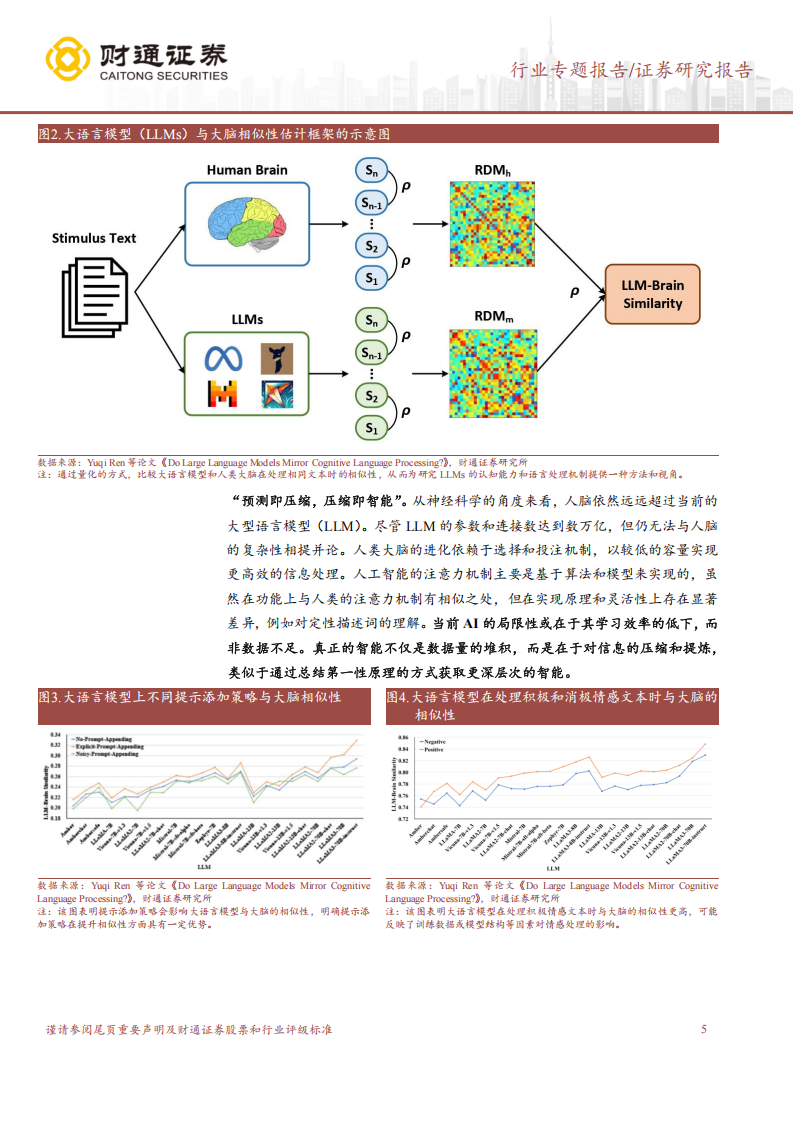

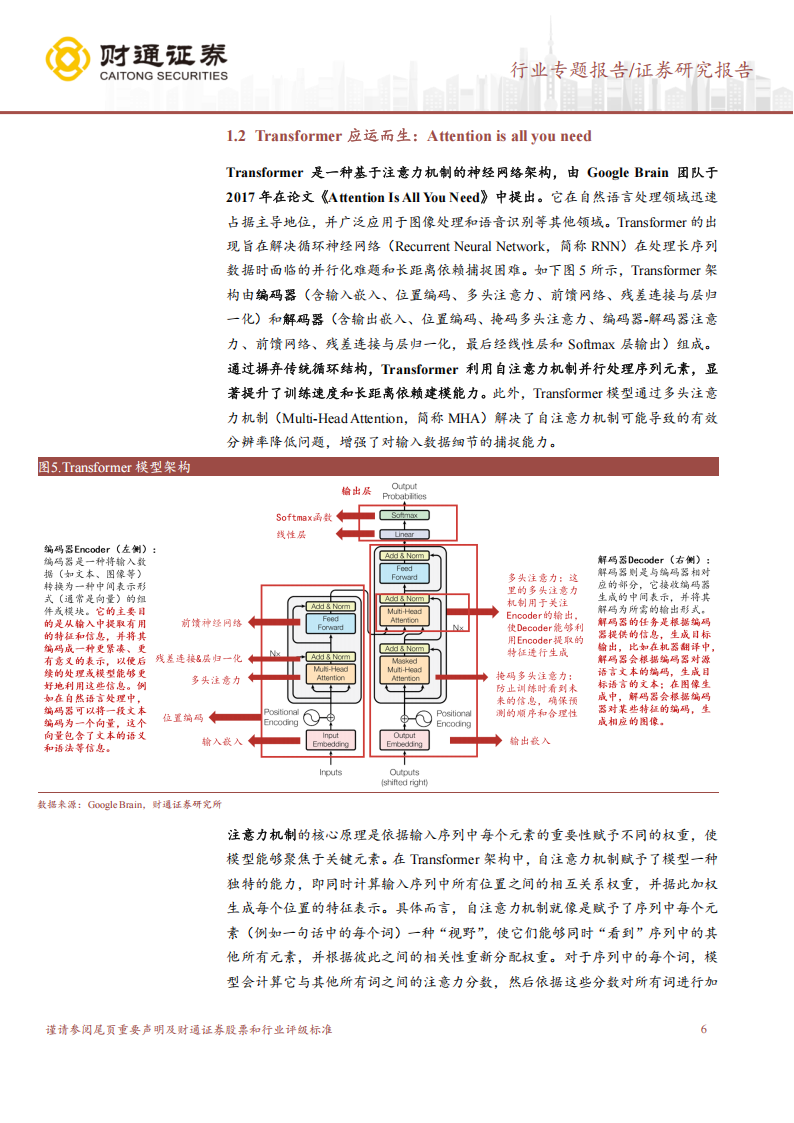

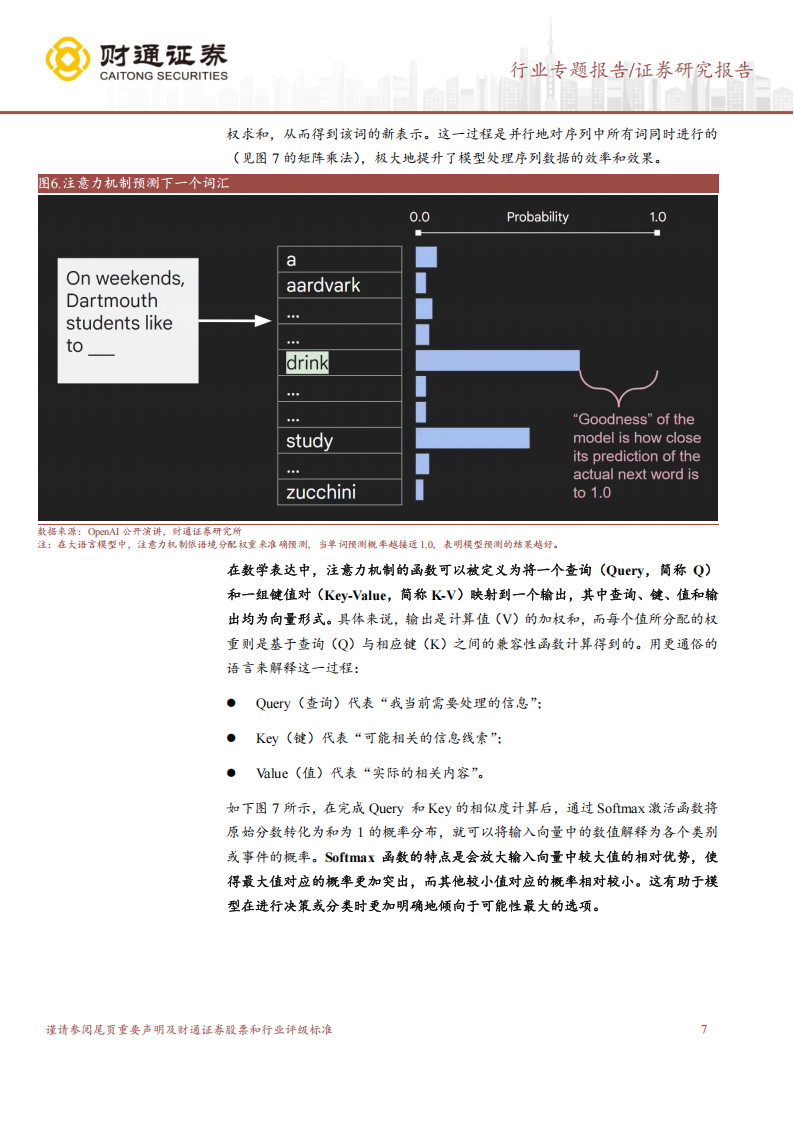

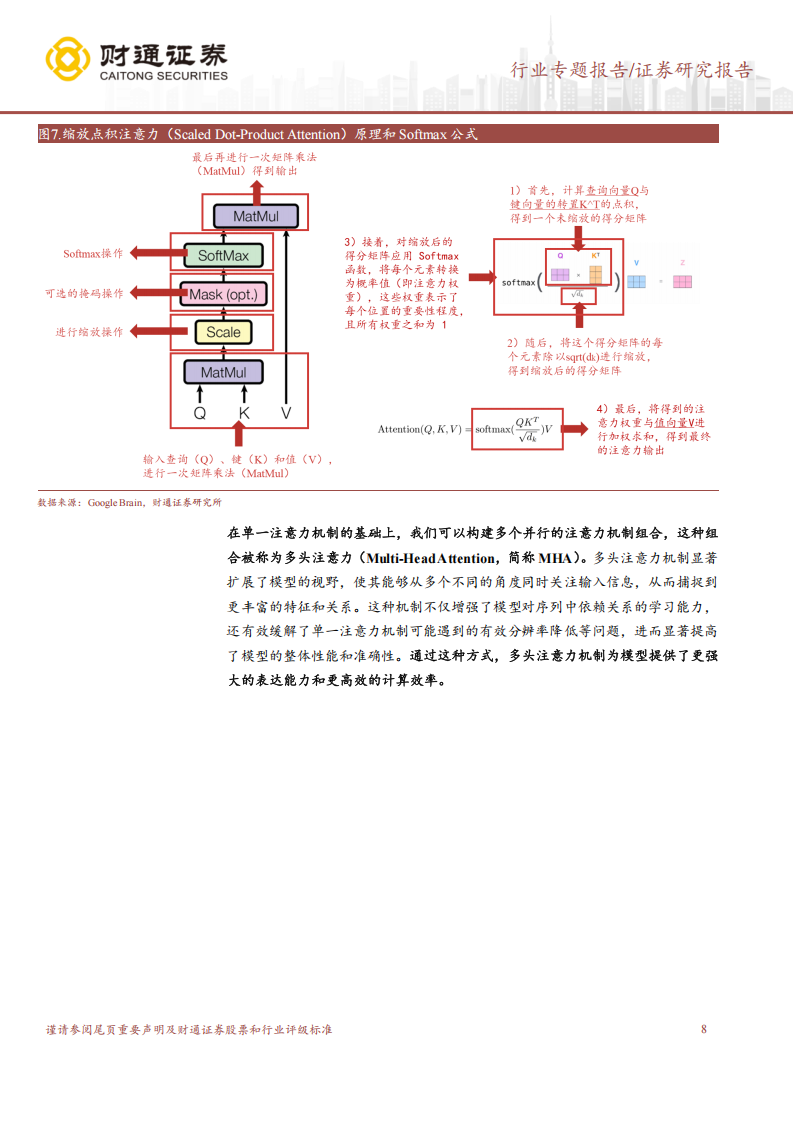

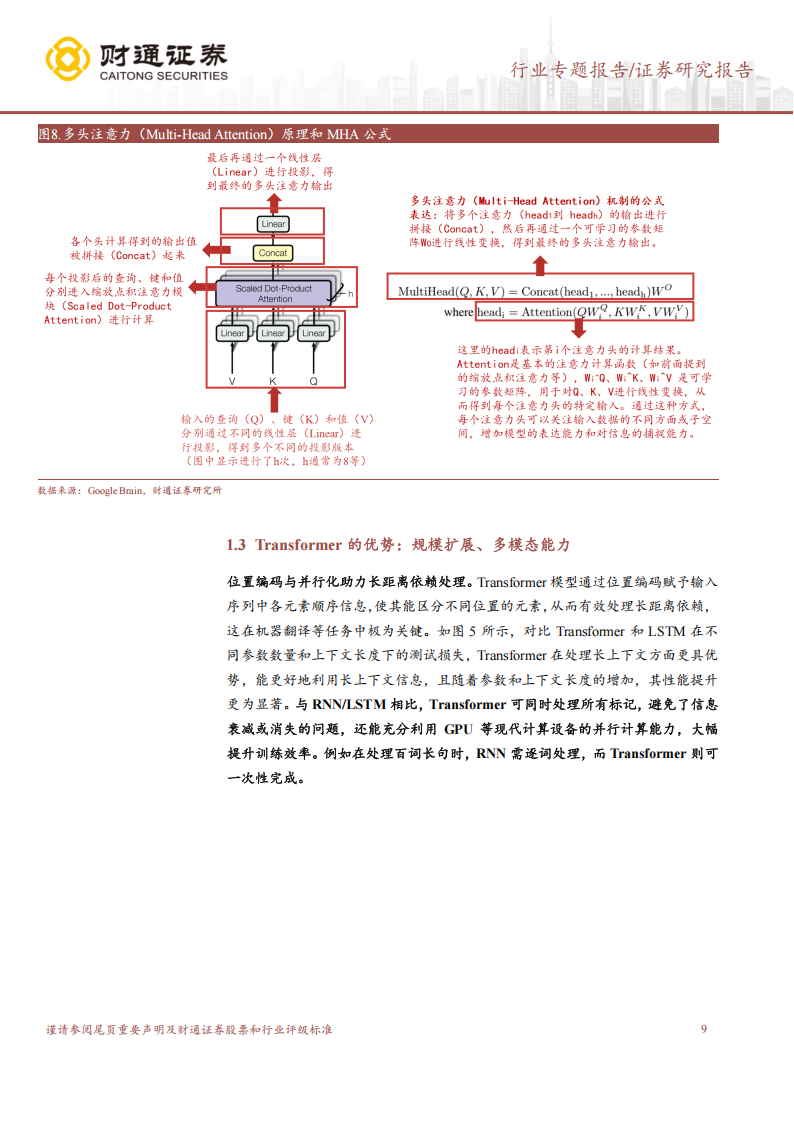

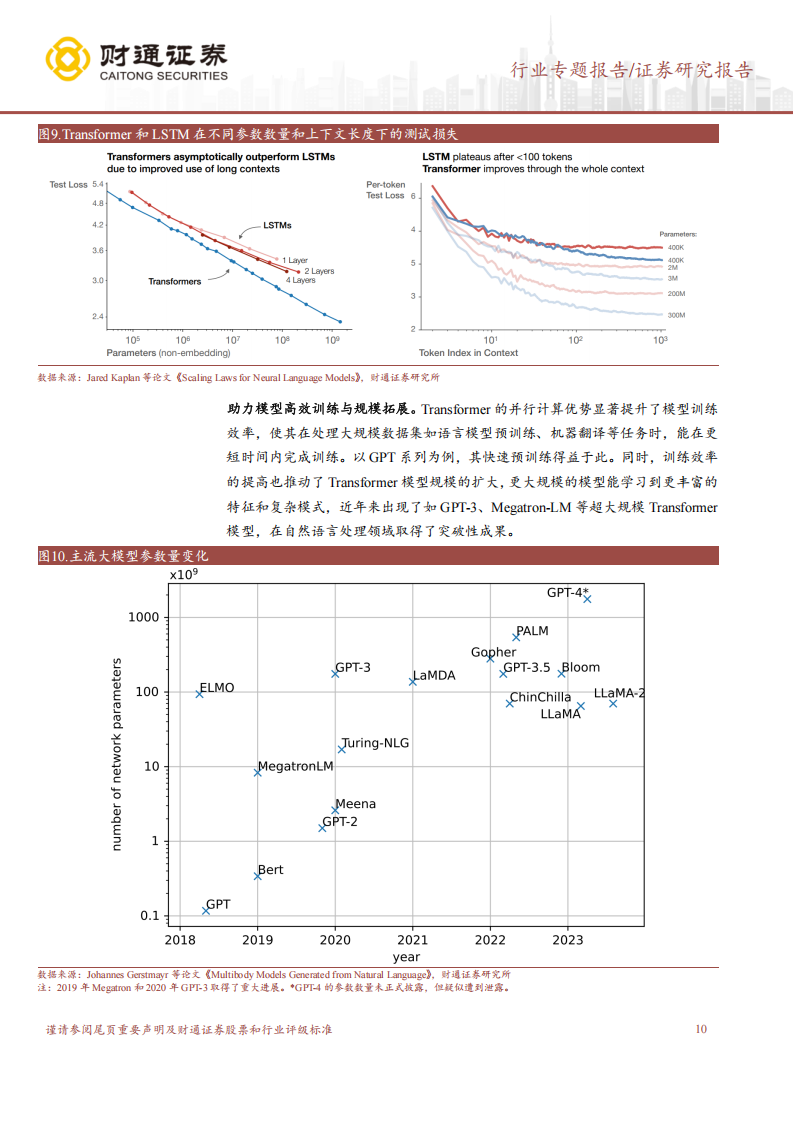

Transformer 架构的过去和现在:人类大脑在有限的资源条件下,通过神经元回路的自组装和微调,实现了高效的信息处理。为了优化信息处理,大脑发展了高效的信息选择和投注机制——注意力,而非依赖超大容量的处理能力。随着我们对大脑认知机制的深入了解以及计算机科学的进步,研究人员尝试通过算法量化大脑的认知功能,将人类的思维模式映射到人工智能上。Transformer 是一种基于注意力机制的神经网络架构,由 Google Brain 团队于 2017 年在论文《Attention Is All You Need》中提出。通过摒弃传统循环结构,Transformer 利用自注意力机制并行处理序列元素,显著提升了训练速度和长距离依赖建模能力。Transformer 架构的灵活性,使其成为众多非自然语言处理领域先进模型构建的基础框架,展现出广阔的应用前景,包括但不限于能够将不同模态的数据映射到统一的特征表示空间,促进跨模态应用发展。目前,人工智能大模型的进化主要依赖于人工版本的更新。而随着技术的发展,研究人员正在探索自我进化的模型,使其能够自主完善和学习由自身生成的经验,从而推动人工智能向更高级的智能发展。当前 AI 的局限性或在于其学习效率的低下,而非数据不足。真正的智能不仅是数据量的堆积,而是在于对信息的压缩和提炼,类似于通过总结第一性原理的方式获取更深层次的智能。